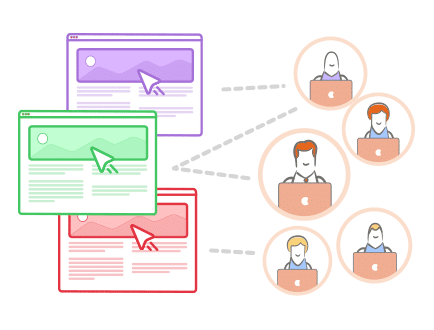

Zahlen lügen nicht. So kann man mit wenigen Worten das Prinzip von A/B-Testing beschreiben. An die Stelle von Spekulationen und Prognosen über die Zielgruppe treten handfeste Daten, die von den Usern selbst stammen. Das Prinzip ist recht einfach: Zwei Varianten einer Website werden ins Netz gestellt. Der A/B-Test misst die unterschiedlichen Konversionsraten. Die bessere Alternative setzt sich durch – und wird bei Bedarf mit weiteren A/B-Tests laufend optimiert.

Was ist A/B-Testing?

A/B-Tests sind Experimente, die im Netz durchgeführt werden. Gemessen wird der Erfolg von zwei oder mehreren unterschiedlichen Varianten einer Website, einer App oder einer Werbekampagne. Im Ergebnis zeigen statistisch signifikante Daten, mit welcher Version ein vorgegebenes Ziel besser erreicht wird.

Dabei merken die User nicht, dass sie an einem Experiment teilnehmen. Auch der Webseitenbetreiber überlässt die Auswahl der Variante dem Zufall – was die Ergebnisse zusätzlich signifikant und glaubhaft macht. Dieses Verfahren ist auch in der Medizin bekannt: Beim sogenannten Doppel-Blind-Test wird die Wirksamkeit eines Medikaments geprüft, indem bestimmten Patienten ein Placebo verabreicht wird (die sogenannte Kontrollgruppe), die anderen erhalten das zu überprüfende Medikament. Dabei wissen beide Beteiligten (der verabreichende Arzt und der Patient) nicht, welches Präparat der Patient erhält. Dieses Unwissen ist aber gerade Voraussetzung dafür, dass der Test funktioniert.

Splitten oder A/B?

Im Internet liest man häufig von sogenannten Split-Tests oder von Split Testing. Welche Bezeichnung ist nun richtig? A/B-Testing oder Split-Test? Der Unterschied ist folgender:

Häufig werden beide Begriffe als Synonyme verwendet. Für Laien ist dieser Unterschied kaum von Bedeutung. Allerdings können Split-Tests nachteilige SEO-Auswirkungen haben. Es besteht die Gefahr, dass Google zwei fast identische Seiten als Duplicate Content einstuft. Daher sollte diese Variante nur genutzt werden, wenn die zu testende Seite deutliche Unterschiede aufweist. Die Alternative wäre, ein Canonical Tag zu setzen. So würde die Testseite auf die Originalseite zeigen, nicht von Google indiziert und auch nicht als Duplicate Content wahrgenommen werden.

Entscheidend ist, dass die Ergebnisse validierbar sind und den Usern tatsächlich zwei Varianten einer Website präsentiert werden, auf denen mindestens ein Element unterschiedlich ist.

A/B-Testing – ein einfaches Prinzip

A/B-Tests beruhen auf einem ganz einfachen Prinzip: Es geht darum, auszuprobieren, was besser ist. Ein Beispiel:

Dies ist natürlich ein sehr einfaches Beispiel. Je größer deine Webseite ist, desto komplexer kann auch der Versuchsaufbau eines A/B-Tests gestaltet werden.

Gesicherte Daten statt Spekulationen

A/B-Tests revolutionieren das Marketing und die Strategien von Start-ups. War es früher erforderlich, vor dem Start detaillierte Pläne für ein Projekt zu entwerfen, ist es heute möglich, ein Projekt sofort online zu stellen und während der Startphase zu prüfen, welche Varianten die Leser ansprechen. Dies spart vor allem Kosten.

A/B-Tests oder Split-Tests setzen auf messbare Daten anstelle von Spekulationen. Wieso besteht überhaupt ein Bedarf an solchen Tests? Die Antwort ist einfach: Oft genug erweisen sich Kampagnen – auch wenn diese von Profis entwickelt wurden und auf Marktforschungsdaten beruhten – im Endeffekt als wenig wirksam.

A/B-Testing bietet dagegen die Möglichkeit, laufende Marketingkampagnen ständig zu optimieren. A/B-Testing ist sozusagen Marktforschung in Echtzeit. Die Entwicklung von Kampagnen reagiert flexibel auf die Reaktionen der Zielgruppe. Dabei werden Erkenntnisse aus der Werbewissenschaft natürlich nicht vernachlässigt. Das Fachwissen von Experten wird vielmehr direkt in einer aktuellen Kampagne angewendet, um auf erste Ergebnisse zu reagieren. So kann zum Beispiel getestet werden,

Auch Aspekte wie Design und Usability können mit A/B-Testing geprüft werden.

Du benötigst noch gute Texte für deine geplanten A/B-Tests?

Der richtige Content für deine Zielgruppe: bequem und einfach erstellen lassen.

Wofür eignet sich A/B-Testing?

Der Einsatzbereich von A/B-Testing ist sehr umfangreich. So eignet sich der statistische Test unter anderem für folgende Werbemaßnahmen oder Elemente auf Websites:

Beim Einsatz von A/B-Tests ist insbesondere bei großen Projekten entscheidend, Makro-Ziele zu setzen, die den Endpunkt der Tests markieren. Sobald eine vorher festgelegte Konversionsrate erreicht ist, kann der Test beendet werden. Es ist aber auch möglich, Tests bis zum Abschluss eines Projekts durchzuführen und kontinuierlich A/B-Testing einzusetzen.

Wie erstelle ich eine gute Hypothese?

Die Hypothese ist die Grundlage eines A/B-Tests. Ohne eine Hypothese experimentiert man letztlich ins Blaue hinein. Als Beispiel soll hier der Text für einen Call-to-Action-Button dienen. So gehst du vor dem Start des Tests vor:

Formulierung der Frage:

Warum klicken nur sehr wenige Besucher auf den Call-to-Action-Button?

Formulierung der Hypothese:

Die Besucher klicken nicht auf den Call-to-Action-Button, weil die Aufforderung zu aggressiv formuliert ist („Hier klicken!“).

Formulierung des Lösungsansatzes:

Die Besucher werden öfter auf den Call-to-Action-Button klicken, wenn die Aufforderung freundlicher und defensiver formuliert ist („Möchtest du mehr erfahren?“).

Formulierung einer klaren Metrik vor dem Test:

Welches Ziel willst du erreichen? Beispiel: Wenn die Klickrate von 5 % auf 10 % steigt, ist die neue Version des Call-to-Action-Buttons besser.

Es ist wichtig, jede Hypothese einzeln unabhängig von anderen Elementen zu testen. Als Faustregel gilt: Bei der Prüfung eines einzelnen Elements sind die Ergebnisse nur dann signifikant, wenn in beiden Versionen alles andere identisch ist.

Wenn dieser Test durchgeführt ist und messbare Ergebnisse bringt, nimmst du weitere Optimierungen vor. Beispiele:

Auf diese Weise wird deine Page nach und nach optimiert. Wichtig: Setze dir bei der Anwendung eines A/B-Tests für jedes Projekt ein Makro-Ziel, das das Ende der Tests markiert.

Was heißt Signifikanz?

Bei jedem A/B-Test fällt irgendwann das Stichwort „Signifikanz“. Im allgemeinen Sprachgebrauch wird dieses Wort im Sinne von „Bedeutsamkeit“ eingesetzt. In der Statistik hat dieser Begriff eine streng definierte Bedeutung.

Ein Ergebnis ist statistisch signifikant,

wenn es nicht mit dem Zufall erklärt werden kann.

Ein einfaches Beispiel:

In einer Kugel befinden sich 100 weiße und rote Kugeln. Wie viele weiße und wie viele rote Kugeln gibt es? Wenn du eine Stichprobe von nur zwei Kugeln nimmst, ist das Ergebnis sicherlich nicht statistisch signifikant. Bei 50 entnommenen Kugeln kannst du jedoch bereits eine fundierte Aussage über die wahrscheinliche Farbzusammensetzung der Kugeln treffen, die auf einer belastbaren Stichprobe beruht. Genauso verhält es sich bei einem A/B-Test. Erst ab einer gewissen Anzahl von Zugriffen kannst du einigermaßen aussagekräftige Vorhersagen über die Treffsicherheit deines Contents machen.

Und wann ist ein A/B-Test signifikant?

Die ersten Ergebnisse eines Split-Tests stehen fest. Variante A zeigt zum Beispiel eine Konversionsrate von 12 Prozent, Variante B erzielt nur 11 Prozent. 2000 Besucher waren auf den Seiten, 1000 bekamen Variante A zu sehen, den anderen 1000 Besucher wurde Variante B präsentiert. Ist das Ergebnis signifikant – also aussagekräftig? Nein, denn ein Unterschied von nur einem Prozentpunkt bei der Konversion liegt noch im Bereich des Zufalls.

Ein ähnliches Beispiel:

Variante A: 10 Besucher, 30 % Conversion

Variante B: 10 Besucher, 50 % Conversion

Auch hier ist das Ergebnis nicht signifikant – trotz des großen Unterschieds bei der Konversionsrate. Bei so wenigen Besuchern kann das Ergebnis auch durch reinen Zufall erklärt werden. Liegt bei Variante A die Konversionsrate jedoch bei 100 % und bei B bei 0 %, ist trotz der wenigen Besucher hier eine gewisse Signifikanz gegeben.

Faustregel:

Ein Ergebnis ist umso zuverlässiger, je mehr Besucher gezählt wurden und je höher der Unterschied bei den gemessenen Werten ist.

Und wenn das Experiment keine signifikanten Unterschiede zeigt? Auch dies ist ein Ergebnis. Denn die Messung zeigt in diesem Fall, dass das Element für die Conversion nicht relevant ist. Weitere Tests zu diesem Element können also entfallen.

Der Berechnung der Statistischen Signifikanz liegt der sogenannte Chi²-Test zugrunde. Die einzusetzenden Variablen für deinen A/B-Test wären dabei:

Besucher der Originalvariante

Besucher der Vergleichsvariante

Conversions der Originalvariante

Conversions der Vergleichsvariante

Gesamtzahl der Besucher

Gesamtzahl der Besucher mit Conversion

Gesamtzahl der Besucher ohne Conversion

Der Wert, um den die eine Variante besser abschneidet als die andere, nennt man den Uplift und du kannst ihn folgendermaßen berechnen:

Um sicherzugehen, dass dein A/B-Test die richtigen Ergebnisse liefert, kannst du Gebrauch von folgenden Online-Rechnern machen:

Schon kleine Texte entscheiden über Klickraten.

Profi-Texter wissen, worauf es ankommt.

Tools für A/B-Testing

Welche Tools gibt es, um die Performance unterschiedlicher Versionen zu testen? An erster Stelle muss natürlich Google Analytics genannt werden. Das Tool vom Marktführer enthält zahlreiche Features für die Conversion-Messung.

Mithilfe von Google Adsense lässt sich beispielsweise der RPM messen (Revenue per Thousand Impressions, Umsatz pro 1000 Besucher). Für diesen Wert sind insbesondere die Platzierungen von Anzeigen auf einer Website entscheidend.

Google Analytics bietet ein sogenanntes A/B-N-Modell an, bei dem nicht nur zwei, sondern bis zu 10 Versionen einer Seite auf ihre Konversion getestet werden können. Wie gehst du hier am besten vor?

Das Ziel oder den Messwert eingeben (hier kann auch der Prozentsatz des Traffics festgelegt werden, der am Experiment teilnimmt).

Den Test konfigurieren: zwei Seiten festlegen, die den Teilnehmern angeboten werden.

Den Testcode in die Seiten einfügen.

Starten und überprüfen.

Auch bei Google Adsense wird das Prinzip von A/B-Testing angewandt. Signifikante Unterschiede der Klickraten verschieden formulierter kleiner Textanzeigen geben Aufschluss darüber, welche Formulierungen wirken.

Wie geht man bei A/B-Testing vor?

A/B-Testing ist ein wissenschaftlicher Prozess, der auf statistischen Erkenntnissen beruht. Es geht um Zahlen – deshalb ist es besonders wichtig, exakt zu arbeiten. Ein professionelles Vorgehen beim A/B-Testing durchläuft folgende Stufen:

Die Chancen und das Potenzial der Website analysieren. Wo gibt es Probleme?

Hypothesen herausarbeiten. Beispiel: Problem A liegt an Ursache B.

Mögliche Lösungen: Problem A kann gelöst werden, indem Ursache B geändert wird.

Bei mehreren Problemen: Hierarchisierung nach Wichtigkeit und Aktualität.

Tests durchführen und Ergebnisse messen.

Nach und nach werden die verschiedenen Probleme in der Reihenfolge ihrer Wichtigkeit gelöst.

Die Frage, welches Problem gelöst werden soll, orientiert sich maßgeblich an der Conversion. Aber welche Conversion ist für den Erfolg entscheidend? Die Antwort darauf gibt das Ziel einer Website:

Die Ergebnisse von A/B-Tests sind immer wieder verblüffend. Oft stellen sich winzige Verbesserungen als entscheidend für Verkaufs- oder Conversion-Erfolge heraus.

A/B-Tests und künstliche Intelligenz

Viele A/B-Test-Tools setzen künstliche Intelligenz ein. Wie funktioniert künstliche Intelligenz (KI, Artificial oder Machine Learning) bei A/B-Tests? Das Tool speichert historische Daten, Live-Daten und Best Practices, um auf dieser Basis Empfehlungen auszusprechen oder die Optimierungen sogar selbst umzusetzen. Algorithmen, die auf KI beruhen, erkennen wiederkehrende Muster, leiten daraus Empfehlungen ab oder steuern Maßnahmen selbstständig. Künstliche Intelligenz ist lernfähig. Während eines laufenden Tests verbessert sich das Programm und optimiert die Aussagefähigkeit der Resultate ständig.

Die Kosten für leistungsfähige A/B-Tools, die auf KI basieren, sind teilweise sehr hoch. Für die meisten Programme gibt es jedoch reduzierte Testversionen.

Multivariate Testing

Vor allem bei Websites mit sehr vielen Besuchern kommt auch das sogenannte Multivariate Testing (MVT) zum Einsatz. Der Versuchsaufbau ist hier sehr viel komplexer. MVT bietet die Möglichkeit, verschiedene Features einer Website gleichzeitig zu testen. So wird nicht nur die Effektivität einzelner Elemente (Headlines, Call-to-Actions, Design usw.) geprüft, sondern auch deren Zusammenhänge.

Ein Beispiel:

Headline A ist (isoliert betrachtet) effizienter als Headline B.

Der Call-to-Action-Button A ist – ebenfalls isoliert betrachtet – genauso effizient wie der Call-to-Action-Button B.

Treten Headline B (die schwächere Headline) und der Call-to-Action-Button A jedoch zusammen auf, ist die Konversion deutlich besser.

Mit Multivariate Testing lässt sich also die beste Kombination der Elemente ermitteln. Im Ergebnis stellt sich hier heraus, dass die an sich schwächere Headline B gegenüber der Headline A als stärker ist, wenn sie zusammen mit dem Call-to-Action-Button A eingesetzt wird.

A/B-Tests für den erfolgreichen Relaunch

Webseitenbetreiber stehen vor einem Relaunch einer Seite oft vor der Frage, für welches Theme sie sich entscheiden wollen. Auch hier helfen A/B-Tests. Mit Theme-Split-Tests geht der Webseitenbetreiber auf Nummer sicher und kann sich für die Optik entscheiden, die bei den Besuchern am besten ankommt. Hierfür gibt es WordPress-Plugins, die sich zum Beispiel Google Analytics zunutze machen.

WordPress ist das beliebteste Content-Management-System. Es eignet sich nicht nur hervorragend für Blogs, sondern wird auch für die Konzeption von Landingpages erfolgreich eingesetzt. Mit A/B-Tests können Seitenbetreiber die Conversion ihrer mit WordPress erstellten Seiten nochmals steigern. Für diesen Zweck gibt es eine Vielzahl von Plugins auf dem Markt.

Bei WordPress-Plugins für A/B-Tests unbedingt darauf achten, mit welcher Version die Tests kompatibel sind.

Mit WordPress-Plugins lassen sich sowohl einzelne Elemente wie auch ganze Pages optimieren.

So erreicht man die Leser

Ein guter Text will gelesen werden. Doch wie erreicht man dieses Ziel angesichts einer Flut von Wortbeiträgen im Internet, die dem User bei einer Google-Anfrage nach einem bestimmten Suchwort präsentiert werden? Entscheidend sind vor allem

Weil diese Webseiten-Elemente so wichtig sind, werden sie häufig auch zum Gegenstand von A/B-Tests. Bei der Formulierung von Überschriften, Titeln und Kurzbeschreibungen kommt es auf jedes Wort an.

Wenn diese drei Elemente stimmen, steigen die Chancen, dass der User eine Seite anklickt. Das ist der erste Schritt. Was dann zählt, ist die Qualität des Textes. Jetzt entscheidet zunächst der erste Absatz, ob der User weiterliest. Der erste Absatz hat wie die oben genannten Elemente die Funktion eines Appetizers.

Als erfolgreiche Stilmittel haben sich bei A/B-Testing unter anderem folgende Text-Eigenschaften herausgestellt:

Dies sind Vorgaben, die auf den ersten Blick einfach wirken. Doch wenn es an die Realisierung geht, stoßen viele ungeübte Schreiber an ihre Grenzen.

Eine erfolgreiche Website arbeitet vor allem psychologisch: So muss sich der Besucher zum Beispiel sofort angesprochen fühlen. Das tut er nur, wenn die Website seine Sprache spricht. Die richtige Tonalität, Ansprache und Formulierung zu finden ist nicht leicht – besonders nicht für Laien. Deshalb sollte man sich von Profis helfen lassen.

Gekonnte Formulierungenpushen die Conversion Rate.

Lass dich von unseren Autoren dabei unterstützen.

Häufige Fehler bei A/B-Tests

Auch bei A/B-Testing werden häufig Fehler gemacht. Die Fehlerquelle liegt jedoch meist nicht in dem Tool selbst, sondern bei der Anwendung und Interpretation der Daten. Die häufigsten Fehler sind:

Aus den ersten Ergebnissen werden vorschnell Schlüsse gezogen.

Lösung: Abwarten, bis die Datenmenge ausreichend groß ist, um signifikante Ergebnisse zu zeigen.

Die Tests laufen nicht an allen sieben Wochentagen und zu jeder Uhrzeit.

Lösung: Alle Wochentage mit den Tests abdecken. Es gibt signifikante Unterschiede zwischen Wochentagen, Tageszeiten usw.

Ein Test wird ins Blaue hinein durchgeführt.

Lösung: Eine Hypothese erstellen, die mit dem Test geprüft wird. Beispiel: Die Kundenansprache mit Du ist effizienter als mit Sie (oder umgekehrt).

Zu viele Variationen werden auf einmal getestet.

Lösung: Die Anzahl der Variationen in Abhängigkeit von der Besucherzahl wählen.

Faustregel: Je mehr Besucher, desto mehr Variationen können gleichzeitig getestet werden. Bei zu wenigen Besuchern ist die Signifikanz schwach. Mehr zu häufigen Fehlern bei A/B-Tests, und wie man sie vermeiden kann, erfährst du hier.

A/B-Tests für die ständige Conversion-Optimierung

A/B-Tests setzen wertvolle Erkenntnisse direkt um. Das ist der Grund dafür, dass A/B-Tests kontinuierlich anwendbar sind. So werden bereits heute bei laufenden Kampagnen A/B-Test ständig eingesetzt – bis zum Schluss der Kampagne. Die ständige Optimierung sieht so aus:

Zunächst werden zwei Versionen online gestellt. Erweist sich eine Version als stärker, bleibt diese online. Zusätzlich wird eine Variation der Sieger-Version erstellt, die wiederum der Hälfte der Besucher gezeigt wird. Und so geht es immer weiter, bis bei der Conversion keine signifikanten Unterschiede mehr erkennbar sind.

Vollautomatische Webseitenoptimierung? Das klingt ein bisschen wie Zukunftsmusik. Aber es ist nicht unwahrscheinlich, dass sich Websites in wenigen Jahren vollständig selbst optimieren.

Handfeste Daten für dein Marketingkonzept

Die Entscheidung für eine bestimmte Strategie wird heute weniger vom Gefühl bestimmt als von konkreten Daten. Entscheidend ist, was dem User gefällt. Um dies herauszufinden, bieten sich A/B-Tests an. Diese werden in Realtime angewendet – während der Laufzeit von Kampagnen können Inhalte laufend optimiert werden. Besonders große Websites mit Millionen Besuchern setzen heute A/B-Tests ein, um Risiken zu minimieren. Die entscheidenden Vorteile von A/B-Tests sind:

Nach wie vor gilt, dass das geschriebene Wort einen großen Einfluss auf Kundengewinnung und Conversions hat. Gute Texte wirken immer. Und mit A/B-Tests wird der Erfolg von Texten messbar.

Deine A/B-Tests sind geplant, aber dir fehlt noch der passende Content?

Finde jetzt den richtigen Autor.

Keine Kommentare vorhanden